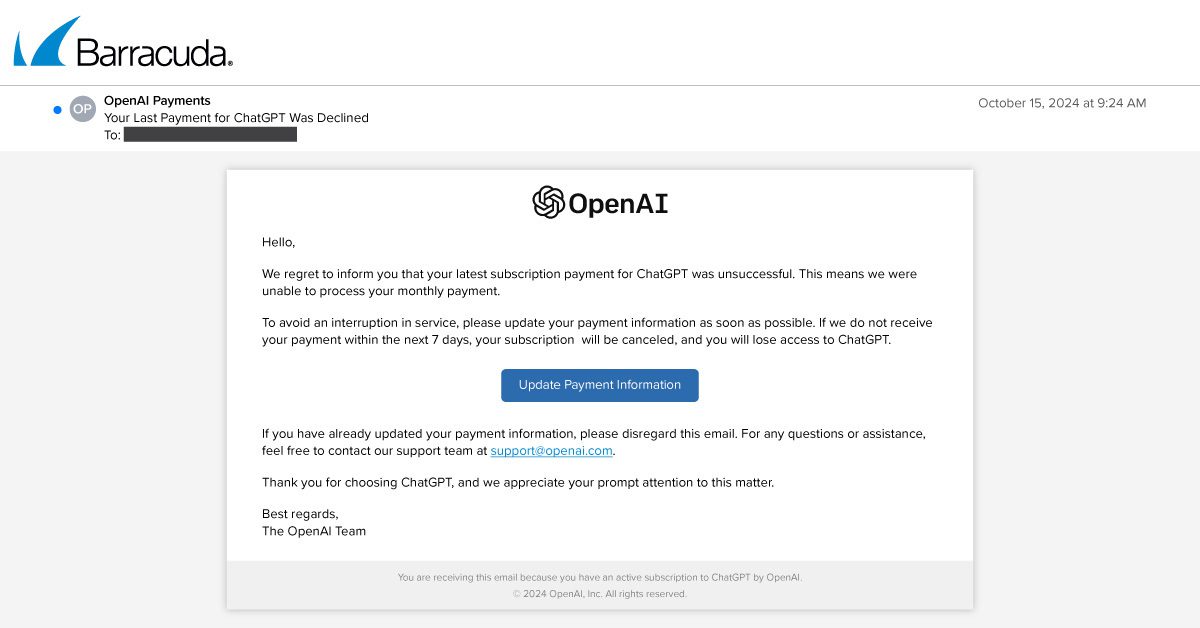

Onderzoekers van Barracuda hebben een grootschalige OpenAI-imitatiecampagne ontdekt, gericht op bedrijven over de hele wereld. Daarbij deden de aanvallers zich voor als OpenAI – het bedrijf achter onder andere ChatGPT – in een urgent e‑mailbericht waarin de ontvangers werd gevraagd om betalingsgegevens bij te werken voor een maandelijks abonnement.

Deze phishing-aanval bevatte een verdacht afzenderdomein en een legitiem ogend e‑mailadres en probeerde een gevoel van urgentie te creëren bij de ontvangers. De e‑mail leek sterk op een legitiem bericht van OpenAI, maar bevatte een versleutelde hyperlink waarbij de daadwerkelijke URL verschilde per e‑mail.

De impact van GenAI op phishing

ChatGPT heeft sinds de lancering veel interesse gewekt bij zowel bedrijven als cybercriminelen. Terwijl bedrijven zich steeds meer zorgen maken over de vraag of hun bestaande securitymaatregelen voldoende bescherming bieden tegen dreigingen die zijn gecreëerd met behulp van generatieve AI-tools, vinden aanvallers telkens weer nieuwe manieren om misbruik te maken van deze tools. Daarbij gebruiken ze AI onder andere om zich te richten op eindgebruikers en maken ze misbruik van potentiële kwetsbaarheden. Dit varieert van het opzetten van overtuigende phishing-campagnes tot het inzetten van geavanceerde methoden voor het verzamelen van logingegevens en het afleveren van malware.

Onderzoeken door Barracuda en door bekende securityanalisten zoals Forrester wijzen wel op een toename van e‑mailaanvallen zoals spam en phishing sinds de lancering van ChatGPT. Het is duidelijk dat GenAI invloed op het volume van aanvallen en het gemak waarmee ze worden gecreëerd, maar voorlopig gebruiken cybercriminelen deze technologie nog steeds vooral om te helpen bij reeds bekende tactieken en aanvallen, bijvoorbeeld om zich voor te doen als een bekend merk.

Uit het 2024 Data Breach Investigations Report van Verizon blijkt dat GenAI vorig jaar in minder dan 100 cyberincidenten werd genoemd. In het rapport staat: “We letten op aanwijzingen voor de groeiende inzet van generatieve artificial intelligence (GenAI) bij aanvallen en de mogelijke effecten van die technologieën. Maar uit de incidentgegevens die we wereldwijd verzamelden kwam niets naar voren.” Verder staat in het rapport dat het aantal vermeldingen van GenAI-termen opvallend laag was, vergeleken met traditionele aanvalsmethoden en ‑vectoren zoals phishing, malware, kwetsbaarheden en ransomware.

Ook analisten van Forrester merkten in hun 2023-rapport op dat tools zoals ChatGPT er weliswaar voor kunnen zorgen dat phishing e‑mails en websites overtuigender en grootschaliger worden, maar dat er weinig aanwijzingen zijn dat generatieve AI de aard van cyberaanvallen fundamenteel heeft veranderd. Het rapport stelt: “Het vermogen van GenAI om overtuigende teksten en afbeeldingen te creëren zal de kwaliteit van phishing e‑mails en websites aanzienlijk verbeteren. Daarnaast kan het fraudeurs ook helpen bij het doen van grootschalige aanvallen.”

Toch is het slechts een kwestie van tijd voordat innovaties in GenAI ertoe zullen leiden dat aanvallers nieuwe en geavanceerdere dreigingen ontwikkelen. Aanvallers zijn ongetwijfeld aan het experimenteren met AI, dus organisaties zouden zich nu al hierop moeten voorbereiden. Waakzaamheid voor signalen die kunnen duiden op traditionele phishing en het versterken van de basisverdediging behoren nog steeds tot de beste manieren waarop bedrijven zich kunnen beschermen tegen evoluerende cyberrisico’s.

Lees voor meer details de blog: https://blog.barracuda.com/2024/10/31/impersonate-openai-steal-data

0 reacties